- 1.34 MB

- 50页

- 1、本文档共5页,可阅读全部内容。

- 2、本文档内容版权归属内容提供方,所产生的收益全部归内容提供方所有。如果您对本文有版权争议,可选择认领,认领后既往收益都归您。

- 3、本文档由用户上传,本站不保证质量和数量令人满意,可能有诸多瑕疵,付费之前,请仔细先通过免费阅读内容等途径辨别内容交易风险。如存在严重挂羊头卖狗肉之情形,可联系本站下载客服投诉处理。

- 文档侵权举报电话:19940600175。

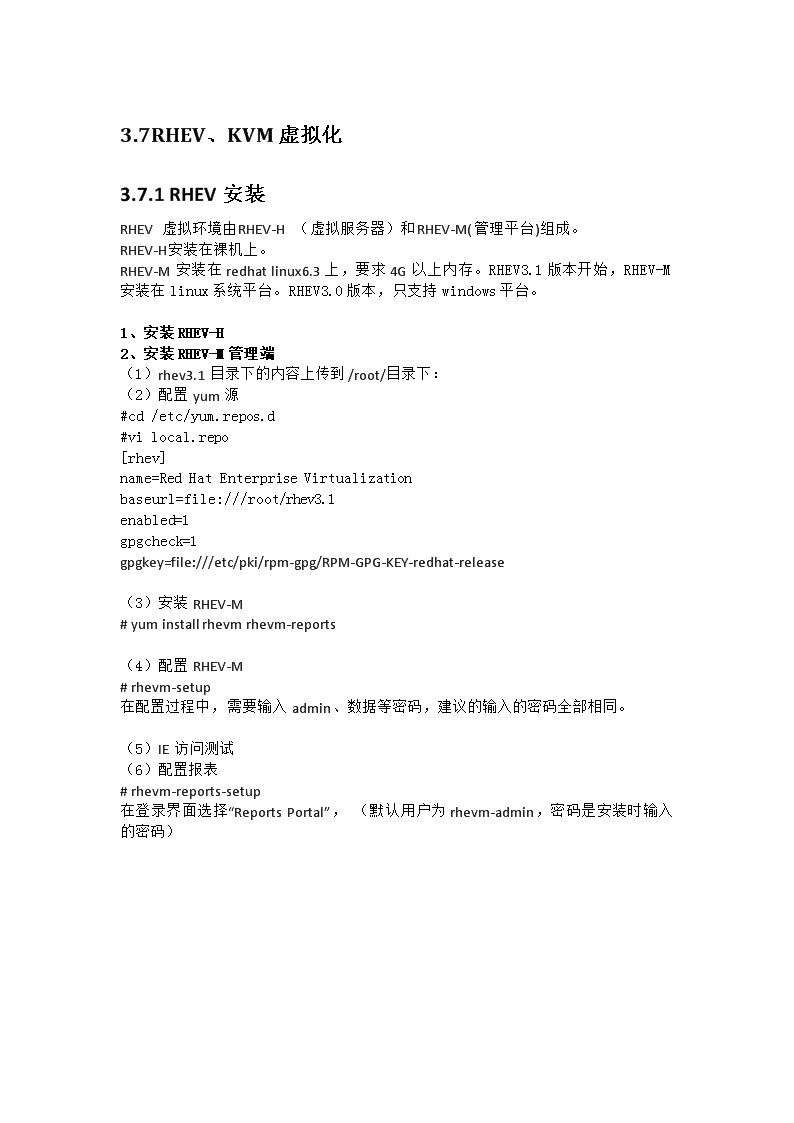

'3.7RHEV、KVM虚拟化3.7.1RHEV安装RHEV虚拟环境由RHEV-H(虚拟服务器)和RHEV-M(管理平台)组成。RHEV-H安装在裸机上。RHEV-M安装在redhatlinux6.3上,要求4G以上内存。RHEV3.1版本开始,RHEV-M安装在linux系统平台。RHEV3.0版本,只支持windows平台。1、安装RHEV-H2、安装RHEV-M管理端(1)rhev3.1目录下的内容上传到/root/目录下:(2)配置yum源#cd/etc/yum.repos.d#vilocal.repo[rhev]name=RedHatEnterpriseVirtualizationbaseurl=file:///root/rhev3.1enabled=1gpgcheck=1gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release(3)安装RHEV-M#yuminstallrhevmrhevm-reports(4)配置RHEV-M#rhevm-setup在配置过程中,需要输入admin、数据等密码,建议的输入的密码全部相同。(5)IE访问测试(6)配置报表#rhevm-reports-setup在登录界面选择“ReportsPortal”,(默认用户为rhevm-admin,密码是安装时输入的密码)

3、RHEV-M管理界面疑问1:KVM在无需共享存储的情况下,可以完成在线物理主机之前的迁移。速度快,base文件相同,仅迁移虚拟机变化数据量。疑问2:RHEV-M、ESXi均无法继承到openstack,除非vmware和redhat开发api疑问3:Pureflex的FSM中不是内置了SCE功能吗???,如果Pureflex算P团队的单,FSM应该内置一个安装SCE云平台的虚拟机。疑问4:KVM的正版授权。3.7.2KVM安装1、重新驱动虚拟机测试物理主机:32C+64GB虚拟机1:8C+32GB

虚拟机2:8C+16GB虚拟机3:8C+16GB同时重启三台虚拟机,发现物理主机内存使用率100%后,使用部分swap分区。然后2-4分钟内逐步内存回收。共六台虚拟机,重启其中三台2、创建虚拟机测试novaboot--availability-zone=nova:Compute-40-F2-E9-11-9B-F9.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.250.240--flavor=win2008_app_8c_16G_300Gwin2008_test_240novaboot--availability-zone=nova:Compute-40-F2-E9-11-9B-F9.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.250.241--flavor=win2008_app_8c_16G_300Gwin2008_test_241novaboot--availability-zone=nova:Compute-40-F2-E9-11-9B-F9.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.250.242--flavor=win2008_app_8c_16G_300Gwin2008_test_242启动所有操作系统后,内存使用率逐渐降低。

3.7.3vnc连接[root@ControlNode~]#/etc/init.d/vncserverstartStartingVNCserver:nodisplaysconfigured[FAILED][root@ControlNode~]#rpm-qa|grepvnctigervnc-1.1.0-5.el6.x86_64novnc-0.4-7.el6.noarchgtk-vnc-0.3.10-3.el6.x86_64tigervnc-server-1.1.0-5.el6.x86_641、启动vncserver与xrdp/etc/init.d/vncserverrestart/etc/init.d/xinetdrestart[root@Compute-40-F2-E9-11-A8-09~]#/etc/init.d/vncserverrestartShuttingdownVNCserver:[OK]StartingVNCserver:2:rootAVNCserverisalreadyrunningas:2[FAILED][root@Compute-40-F2-E9-11-A8-09~]#[root@Compute-40-F2-E9-11-A8-09~]#vncserver-listTigerVNCserversessions:XDISPLAY#PROCESSID:144760[root@Compute-40-F2-E9-11-A8-09~]#2、查看物理主机的vnc配置[root@Compute-40-F2-E9-11-A8-09~]#netstat-an|grep59tcp000.0.0.0:59000.0.0.0:*LISTENtcp000.0.0.0:59010.0.0.0:*LISTENtcp000.0.0.0:59020.0.0.0:*LISTENtcp000.0.0.0:59030.0.0.0:*LISTENtcp000.0.0.0:59040.0.0.0:*LISTEN[root@Compute-40-F2-E9-11-A8-09~]#virshlist--allIdNameState

----------------------------------------------------1instance-000001f2running2instance-000001f5running3instance-000001f3running4instance-000001f4running5instance-0000020arunning-tempshutoff3.7.4KVM迁移测试1、创建测试云主机novaboot--availability-zone=nova:Compute-40-F2-E9-11-B4-E1.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.xx.xx--flavor=win2008_app_2C_2G_50Gwin2008_app_2422、在KVM中将instance-0000020b实例迁移到192.168.200.235主机上Migrate过程:迁移是qemu中支持的,libvirt只是封装好命令并传递给qemu的监控模块。直接将xml和img拷贝到目的主机就ok了virsh命令行迁移:migrateinstance-0000020bqemu://10.10.10.1/system(tls模式)migrateinstance-0000020bqemu+ssh://root@192.168.200.235/system(ssh模式)migrateinstance-0000020bqmeu+tcp://10.10.10.1/system(tcp模式)迁移问题1:Unabletomigrateguest:Unabletopre-createchardevfile"/var/lib/nova/instances/10172a9e-c62a-4fdf-85a8-6e77c13f2be9/console.log":Nosuchfileordirectory解决办法:手动拷贝缺少的目录和文件scproot@192.168.200.234:/var/lib/nova/instances/10172a9e-c62a-4fdf-85a8-6e77c13f2be9//var/lib/nova/instances/迁移问题2:Unabletomigrateguest:CannotgetinterfaceMTUon"qbr755c3e6e-7e":Nosuchdevice

命令行迁移:virshmigrateinstance-0000020bqemu+ssh://root@192.168.200.235/systemroot@192.168.200.235"spassword:error:CannotgetinterfaceMTUon"qbr755c3e6e-7e":Nosuchdevice解决办法:在目标主机brctladdbrqbr755c3e6e-7e[root@Compute-40-F2-E9-11-B4-E1dev]#brctlshowbridgenamebridgeidSTPenabledinterfacesqbr3e5625e2-1c8000.66771487c9a4noqvb3e5625e2-1ctap3e5625e2-1cqbr755c3e6e-7e8000.d21fbb138facnoqvb755c3e6e-7etap755c3e6e-7eqbrdbe5471c-358000.ee472072a8b6noqvbdbe5471c-35tapdbe5471c-35qbrde6b266f-928000.7a1927525f9anoqvbde6b266f-92tapde6b266f-92迁移问题3:Unabletomigrateguest:Networkfilternotfound:Couldnotfindfilter"nova-instance-instance-0000020b-fa163eb2f9f5"察看nova.conf是否启用了如下参数:firewall_driver=nova.virt.firewall.IptablesFirewallDriver如果启用,注释掉并重启nova-compute服务迁移问题4:必须用nova命令迁移,kvm目前暂不支持vswitchnovalive-migrationwin2008_app_242Compute-40-F2-E9-11-9B-F9.kvm.cloud--block-migrateERROR:Livemigrationofinstance10172a9e-c62a-4fdf-85a8-6e77c13f2be9tohostCompute-40-F2-E9-11-9B-F9.kvm.cloudfailed(HTTP400)(Request-ID:req-90808625-88da-44c9-b601-d5f085d370fa)检查发现:novalist虚拟机状态shutoffDestinationDiskExists_Remote:Thesupplieddiskpath(/var/lib/nova/instances/10172a9e-c62a-4fdf-85a8-6e77c13f2be9)alreadyexists,itisexpectednottoexist.解决方法:目标端删除10172a9e-c62a-4fdf-85a8-6e77c13f2be9目录迁移问题5:再次nova迁移虚拟机成功。novalive-migrationwin2008_app_242Compute-40-F2-E9-11-9B-F9.kvm.cloud--block-migrate

3.8openstack云平台云计算是一种计算模型,它将诸如运算能力、存储、网络和软件等资源抽象成为服务,以便让用户通过互联网远程享用,付费的形式也如同传统公共服务设施一样。l 基础设施即服务(IaaS)l 平台即服务(PaaS)l 软件即服务(SaaS)

3.8.1openstack架构Chefserver:openstack的快速部署工具,类似StackOps、Dell的CrowBar、Rackspacganliaserver:跨平台可扩展的,高性能计算系统下的分布式监控系统nagiosserver:监控Horizon:openstackdashboardopenstack-nova-api:openstack-nova-compute:运行虚拟机实例最主要的服务openstack-nova-volume:块存储服务,安装在控制节点,这个物理主机提供volume的创建、删除、挂载等管理功能。openstack-nova-network:openstack-nova-cert:Nova证书管理服务,用来为Nova提供身份验证。openstack-nova-scheduler:管理调度服务器满足对运行虚拟机的请求。openstack-nova-objectstore:文件存储服务。openstack-nova-common:OpenStack环境的基础Python库。quantum-server:接受APIrequests然后把他们转发到合适的quantum插件去执行。quantum-openvswitch-agent:运行在每个hypervisor主机上,提供虚拟交换配置服务。openstack-glance-api:虚拟机镜像发现、注册、检索,将虚拟机镜像存储任何一种存储中。openstack-glance-registry存储和检索镜像的元数据,实际的ImageBlob存储在ImageStore中openstack-glance-scrubber

openstack-cinder-api:接受APIrequests并且将他们转发到cinder-volume去执行。openstack-cinder-volume:处理cinder数据库的维护状态的读写请求,通过消息队列和直接在块存储设备或软件上与其他进程交互。openstack-cinder-scheduler:选择在最优的块存储提供节点上去创建卷。rabbitmq-server:消息队列服务。ntp:网络时间协议,保持相同的时钟。(可容忍的误差在5秒以内,否则将会出现不可预知的结果)3.8.1.1、nava安装配置1、控制节点安装#安装消息队列服务器(rabbitmq)、nova-api、nova-network、nova-objectstore(glance依赖)、nova-scheduler、nova-compute、nova-volume(如果卷服务不在控制节点不需要安装)#编辑/etc/nova/nova.conf,改成如下内容(nova配置文件范例)--dhcpbridge_flagfile=/etc/nova/nova.conf#dhcp桥接配置文件位置--dhcpbridge=/usr/bin/nova-dhcpbridge#桥接命令位置--logdir=/var/log/nova#nova日志存放路径--state_path=/var/lib/nova#nova状态文件位置--lock_path=/var/lock/nova#lock文件位置,以为为pid相关--force_dhcp_release=True#dhcp释放--use_deprecated_auth=1#是否启用外部认证,比如keystone--verbose=1#启用详细日志消息--libvirt_type=kvm#通过libvirt连接的虚拟化程序名称--s3_host=60.12.206.111#objectstore服务地址--rabbit_host=60.12.206.111#rabbitmq队列服务器地址

--cc_host=60.12.206.111#nova-api服务地址--ec2_url=http://60.12.206.111:8773/services/Cloud#nova-api接口地址--fixed_range=10.0.0.0/24#运行实例分配ip范围段--floating_range=60.12.206.0/24#分配给实例的外网ip范围段--network_size=256#网络主机数--routing_source_ip=60.12.206.111#路由地址,当实例得到外网ip,对外的snat地址将是这个地址--sql_connection=mysql://nova:nova@localhost/nova#数据库连接参数--glance_host=60.12.206.111#glance服务地址--image_service=nova.image.glance.GlanceImageService#默认存储镜像使用的服务--network_manager=nova.network.manager.FlatDHCPManager#默认网络模式--flat_network_dhcp_start=10.0.0.2#dhcp分配给的ip的启示地址--public_interface=eth0#公共接口设定--flat_interface=eth1#私有接口设定--connection_type=libvirt#启动虚拟机的驱动--flat_network_bridge=br0#默认的桥接卡2、计算节点安装(1)#安装nova-compute(2)#编辑/etc/nova/nova.conf,改成如下内容(nova配置文件范例)

--dhcpbridge_flagfile=/etc/nova/nova.conf#dhcp桥接配置文件位置--dhcpbridge=/usr/bin/nova-dhcpbridge#桥接命令位置--logdir=/var/log/nova#nova日志存放路径--state_path=/var/lib/nova#nova状态文件位置--lock_path=/var/lock/nova#lock文件位置,以为为pid相关--verbose=1#启用详细日志消息--libvirt_type=kvm#通过libvirt连接的虚拟化程序名称--s3_host=60.12.206.111#objectstore服务地址--rabbit_host=60.12.206.111#rabbitmq队列服务器地址--cc_host=60.12.206.111#nova-api服务地址--ec2_url=http://60.12.206.111:8773/services/Cloud#nova-api接口地址--sql_connection=mysql://nova:nova@localhost/nova#数据库连接参数--glance_host=60.12.206.111#glance服务地址--image_service=nova.image.glance.GlanceImageService#默认存储镜像使用的服务--network_manager=nova.network.manager.FlatDHCPManager#默认网络模式--connection_type=libvirt#启动虚拟机的驱动--glance_api_servers=60.12.206.111:9292#glance-api服务运行地址

3.8.1.2、glance配置1、配置glance使用keystone认证:(1)更新/etc/glance/glance-api-paste.ini的以下选项为keystone中的设置值:(2)在/etc/glance/glance-api.conf尾添加:[paste_deploy]flavor=keystone(3)更新/etc/glance/glance-registry-paste.ini的以下选项为keystone中的设置值(4)在/etc/glance/glance-registry.conf尾添加:[paste_deploy]flavor=keystone2、设置glance的mysql连接:修改/etc/glance/glance-registry.conf下的sql_connection=mysql://glance:glance@localhost/glance3、配置glance的通信服务器:修改/etc/glance/glance-api.conf下的:notifier_strategy=noop为:notifier_strategy=rabbitrabbit_password=guest为:rabbit_password=service1234、glance命令glance--helpglanceindex查看上传的镜像3.8.1.3、quantum配置1、编辑/etc/quantum/quantum.conf文件并修改:

2、虚拟交换机配置编辑/etc/quantum/plugins/openvswitch/ovs_quantum_plugin.ini文件并修改:3、编辑/etc/quantum/api-paste.ini文件并修改:4、/etc/libvirt/qemu.conf5、网络其他组件支持隧道的VirtualBridging(Open-vSwitch+QuantumAgent)DHCPServer(QuantumDHCPAgent) VirtualRouting(QuantumL3Agent)3.8.1.4、cinder配置Cinder替代以前的Novavolume1、编辑/etc/cinder/cinder.conf文件并修改:2、命令cinderlist等同于以前novavolume-listcindershow 65d23a41-b13f-4345-ab65-918a4b8a6fe6列出当前用户的所有资源cinderabsolute-limits 列出volume快照cindersnapshot-list3.8.1.5、文件系统计算节点192.168.200.232-----237[root@Compute-40-F2-E9-11-B4-59~]#df-hFilesystemSizeUsedAvailUse%Mountedon/dev/mapper/rootvg-lvroot49G2.9G43G7%/tmpfs32G032G0%/dev/shm/dev/sdi1504M45M435M10%/boot/dev/mapper/openstackvg-lv_glance301G7.3G278G3%/opt/lbs/lv_glance/dev/mapper/36005076802810d4018000000000000052.0T7.2G1.9T1%/vmdatalocalhost:/lbs_vms6.0T7.6G5.6T1%/var/lib/nova/instances

计算节点192.168.200.231[root@ControlNode~]#df-hFilesystemSizeUsedAvailUse%Mountedon/dev/mapper/lbs-lvroot49G3.9G42G9%/tmpfs32G032G0%/dev/shm/dev/sdi1504M44M435M10%/boot/dev/mapper/lbs-lvimage296G75G206G27%/opt/lbs/dev/mapper/36005076802810d4018000000000000012.0T209M1.9T1%/vmdata/dev/mapper/lbs-lv_glance190G197M180G1%/opt/lbs/lv_glance虚拟CC192.168.200.230[root@CloudControllerhome]#df-hFilesystemSizeUsedAvailUse%Mountedon/dev/mapper/vg_lbscontroller-lv_root40G18G20G48%/tmpfs3.9G03.9G0%/dev/shm/dev/vda1504M43M436M9%/boot/dev/mapper/vg_lbscontroller-lv_home55G7.3G45G14%/home虚拟NC192.168.200.229[root@NetworkControllerimages]#df-hFilesystemSizeUsedAvailUse%Mountedon/dev/mapper/vg_lbscontroller-lv_root20G2.8G16G15%/tmpfs1.9G01.9G0%/dev/shm/dev/vda1504M43M436M9%/boot/dev/mapper/vg_lbscontroller-lv_home28G172M26G1%/homeControlNode.kvm.cloud:lbs_glance790G12G739G2%/var/lib/glance/images3.8.1.6、查看网络流量和硬盘速度#sar-nDEV-u110 看看当前网络流量 #iostat-t110 看看当前硬盘读写速度

3.8.2、openstack管理2.8.2.4、VMHA---虚拟机高可用服务(vmha只在cc配置)1、cd/opt/lbs/conf/vmha(其他主机均没有该目录,只有CC有)[root@CloudControllerbin]#more/opt/lbs/conf/vmha.conf#openstackkeystoneinfo.OS_USERNAME=adminOS_PASSWORD=Passw0rdOS_TENANT_NAME=adminOS_AUTH_URL=http://192.168.200.229:5000/v2.0#ifglusterfscheckenabledGLUSTERFS_CHECK_ENABLED=0#numberofpingfailed,host-evacuatewilloccurFAILED_THREADHOLD=6#eachpingintervalPING_INTERVAL=1#eachpingtimeout.Afterthissecond,webelieveafailedping.PING_TIMEOUT=2#If"STONITH"isenabled,vmhawilltrytorebootthefailedhost.STONITH_ENABLED=1#debugflagDEBUG=0#immaddrinfousedtorebootthemachinewhenfailedIMM_INFO_FILE="/opt/lbs/conf/imm_info.cfg"#vmhafilter.ifset,vmhawillnotmonitortheserviceofthesecomputenode.#Use,toseperatemultiplenodes,VMHA_HOST_FILTER=ControlNode.kvm.cloud2、IMM配置测试imm连接/opt/ibm/toolscenter/asu/asu64immapp--host192.168.200.207powerstatevim/opt/lbs/conf/imm_info.cfgCompute-40-F2-E9-11-9B-F9.kvm.cloud192.168.200.219adminPassw0rdCompute-40-F2-E9-11-B4-E1.kvm.cloud192.168.200.207adminPassw0rdCompute-40-F2-E9-11-B4-59.kvm.cloud192.168.200.218adminPassw0rdCompute-40-F2-E9-11-A8-09.kvm.cloud192.168.200.217adminPassw0rdCompute-40-F2-E9-11-A8-41.kvm.cloud192.168.200.208adminPassw0rd3、安装./vmha_install.sh

4、查看vmha状态/etc/init.d/vmhastatusps-ef|grepvmhaservicevmhastatusfind.-name"*.py"-print|xargsgrep"rpc_response"./chef_exec.shcn"cat/etc/resolv.conf"knifenodelistknifenodeshow./chef_exec.shcn"ls"./chef_exec.shcn"hostname-f"./chef_exec.shcn"fdisk-l"./chef_exec.shcn"mount"./chef_exec.shcn"mount-a"glance-controlall./chef_exec.shcn"lsmod|grepbridge"2.8.2.5、集群文件系统./chef_exec.shcn"umount/var/lib/nova/instances"./chef_exec.shcn"mount-a"./chef_exec.shcn"mount-a"./chef_exec.shcn""./chef_exec.shcn"umount/var/lib/nova/instances"./chef_exec.shcn"mount-a"./chef_exec.shcn"umount/var/lib/nova/instances"./chef_exec.shcn"rm-rf/vmdata/.glusterfs/"./chef_exec.shcn"mount-a"./chef_exec.shcn"chown-Rnova:nova/var/lib/nova/instances"glusterpeerstatus2.8.2.6、镜像管理重新启动serviceglance-apirestart&&serviceglance-registryrestart重新同步glance数据库glance-managedb_sync

查看镜像glanceindexIDNameDiskFormatContainerFormatSize------------------------------------------------------------------------------------------------------------------------b3d8fc40-6a00-4f28-8905-a4ce3e96e2c6win2008r2sp1qcow2bare7566983168d71015e5-97fa-4b5a-b6fe-332644f71552RHEL6.4.isoisobare37203476481f245aea-063d-44ef-b755-ae023b03e1c5cirrosqcow2bare9761280glanceimage-list[root@CloudControllerbin]#glanceshowb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6URI:http://192.168.200.229:9292/v1/images/b3d8fc40-6a00-4f28-8905-a4ce3e96e2c6Id:b3d8fc40-6a00-4f28-8905-a4ce3e96e2c6Public:YesProtected:NoName:win2008r2sp1Status:activeSize:7566983168Diskformat:qcow2Containerformat:bareMinimumRamRequired(MB):0MinimumDiskRequired(GB):0Owner:53b8fccb076746a980b5840af8d5886fCreatedat:2013-11-27T11:07:25Updatedat:2013-11-27T11:11:42查看flavornovaflavor-listnovaimage-list查看虚拟机novashowsuperfrobnicator 注意:在创建存储池时,需要在主存储服务器依次创建附加服务器的peers,主服务器不需要添加。2.8.2.7、检查keystone设置是否正确keystoneuser-list

+-------------------------------------------------------+----------------+---------+-------+|id|name|enabled|email|+-------------------------------------------------------+----------------+------------+----------+|b95a99f899ff4a2db458f010202dd4aa|admin|True|||f2aff4cfe0f34bf68e8ba6ec0ef534cd|ec2|True|||20d39b6f75664491a098281cad8585ad|glance|True|||cf06608849514625b1cfbc5dcf962881|nova|True|||69434f9591814d4f87603d4d7339ebec|quantum|True|||7c32de5b53e943f38e8e198bd168f83e|swift|True||+--------------------------------------------------------+-------------+---------------+-----------+keystoneendpoint-listkeystonetenant-list+--------------------------------------------------------+----------------+-----------+|id|name|enabled|+-------------------------------------------------------+-----------------+-----------+|53b8fccb076746a980b5840af8d5886f|admin|True||09e262b9327046cdb08bbb1ac1612438|service|True|+---------------------------------------------------------+------------+-------------+keystonerole-list|9fe2ff9ee4384b1894a90878d3e92bab|_member_||824df0e344de45ef8f3687e64661ade4|admin|2.8.2.8、vnc无法打开一个nova-consoleauth进程。通常运行在控制器主机上。一个或多个nova-novncproxy服务。该服务提供基于浏览器的novnc客户端访问。一个或多个nova-xvpvncproxy服务。该服务提供基于Java的客户端访问。一个或多个compute节点。需要对compute节点进行正确配置。重新启动cc端两个服务/etc/init.d/openstack-nova-xvpvncproxyrestart/etc/init.d/openstack-nova-xvpvncproxyrestart

2.8.2.9、重新扫描磁盘2.8.2.10、快照管理1、创建快照(1)云主机d盘安装了rar,创建快照发现物理主机存在以下操作:qemu-imgconvert-fqcow2-Oqcow2-s52576f18bb1c414896a012d859870146/var/lib/nova/instances/d84a5ee9-de3c-4d7a-a945-0442c8deb6db/disk/var/lib/nova/instances/snapshots/tmpL6dR19/52576f18bb1c414896a012d859870146qemu-imgconvert-fqcow2-Oqcow2-s16585801bf7546a485e119a710b84337/var/lib/nova/instances/d84a5ee9-de3c-4d7a-a945-0442c8deb6db/disk/var/lib/nova/instances/snapshots/tmpiK20sF/16585801bf7546a485e119a710b84337disk400MBtmpL6dR19目录7.1GB将DISK文件写入16585801bf7546a485e119a710b84337文件中。(2)快照保存操作(所有image、snapshot均在NC节点保存)在192.168.200.299/var/lib/glance/images目录下生成b7a68c63-8745-4169-8118-6ca7fc066035快照文件,速度约100MB/s[root@NetworkControllerimages]#glanceindexIDNameDiskFormatContainerFormatSize------------------------------------------------------------------------------------------------------------------------------------b7a68c63-8745-4169-8118-6ca7fc066035win2008_240_snapshotqcow2bare7584415744b3d8fc40-6a00-4f28-8905-a4ce3e96e2c6win2008r2sp1qcow2bare7566983168d71015e5-97fa-4b5a-b6fe-332644f71552RHEL6.4.isoisobare37203476481f245aea-063d-44ef-b755-ae023b03e1c5cirrosqcow2bare9761280云主机状态

2、从快照部署云主机(1)指定从某个image部署云主机novaboot--availability-zone=nova:Compute-40-F2-E9-11-B4-E1.kvm.cloud--imageb7a68c63-8745-4169-8118-6ca7fc066035--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.250.241--flavor=win2008_app_8c_16G_300Gwin2008_test_241(2)状态(很慢约10min)-----------在物理主机的/var/lib/nova/instances/_base目录下生成一个*.part的文件(7.1GB)-----------将part文件conver到一个300GB的base文件中-----------云主机active很慢,文件需要convert快照部署虚拟机过程:拷贝一个part------将part文件conver到base(300GB)文件中----完成/var/lib/nova/instances/_base37GDec611:36b03bbf8da17ce43c4f453a3cd92d040b4d8bf499300GDec611:551a48c6171fea451f868a9ef826d7fc7479f147ab.converted7.1GDec611:551a48c6171fea451f868a9ef826d7fc7479f147ab.part查看conver操作命令[root@Compute-40-F2-E9-11-B4-59_base]#ps-ef|grepimgqemu-imgconvert-Oraw/var/lib/nova/instances/_base/1a48c6171fea451f868a9ef826d7fc7479f147ab.part/var/lib/nova/instances/_base/1a48c6171fea451f868a9ef826d7fc7479f147ab.converted(3)部署完成物理主机/var/lib/nova/instances/_base下生成一个base文件37GDec611:36b03bbf8da17ce43c4f453a3cd92d040b4d8bf499300GDec611:551a48c6171fea451f868a9ef826d7fc7479f147ab

说明:如何查找虚拟机在物理主机对应的base文件名(4)部署完成后,却确认没问题,可以删除快照(节省7.1GBimage空间而已)3、删除快照部署的虚拟机(1)查看虚拟机对应的物理主机[root@CloudController~]#novashowwin2008_test_241(2)删除虚拟机(3)删除快照如果确认所有快照部署的虚拟机都确认删除,可以删除快照。(4)删除物理主机的base文件说明:如何查找虚拟机对应的base文件,每个快照部署的虚拟机的物理主机都会生成一个base文件。4、快照部署和镜像部署的区别存储空间区别:快照部署base文件大占用空间;而image镜像部署方式,只占用了37GB空间。/var/lib/nova/instances/_base37GDec611:36b03bbf8da17ce43c4f453a3cd92d040b4d8bf499300GDec611:55c5a099175d16e78106272124f9f540ca14c45e56.converted

3.8.3nova虚拟机管理qemu-imgcreate-fraw/var/lib/nova/instances/_base/ephemeral_240_default240Gqemu-imgcreate-fraw/tmp/ss.img1Gnovaboot--availability-zone=nova:Compute-40-F2-E9-11-B4-59.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=56f24353-a38a-4c77-8c45-26b39b2e565c--flavor=win2008_app_16c_32G_300Gwin12.8.3.1命令行创建云主机export OS_PASSWORD="Passw0rd" export OS_USERNAME="admin" export OS_TENANT_NAME="admin" exportOS_AUTH_URL=http://192.168.200.229:35357/v2.0[root@CloudController~]#glanceindexIDNameDiskFormatContainerFormatSize------------------------------------------------------------------------------------------------------------------------b3d8fc40-6a00-4f28-8905-a4ce3e96e2c6win2008r2sp1qcow2bare7566983168d71015e5-97fa-4b5a-b6fe-332644f71552RHEL6.4.isoisobare37203476481f245aea-063d-44ef-b755-ae023b03e1c5cirrosqcow2bare9761280[root@Compute-40-F2-E9-11-A8-09~]#quantumnet-list|id|name|subnets||56f24353-a38a-4c77-8c45-26b39b2e565c|Vlan100||以win2008r2sp1为镜像,win2008_app_16c_32G_300G为flavor,创建云主机win1在物理主机Compute-40-F2-E9-11-B4-59.kvm.cloudnovaboot--availability-zone=nova:Compute-40-F2-E9-11-B4-59.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=56f24353-a38a-4c77-8c45-26b39b2e565c--flavor=win2008_app_16c_32G_300Gwin1novaboot--availability-zone=nova:Compute-40-F2-E9-11-B4-E1.kvm.cloud--imageb3d8fc40-6a00-4f28-8905-a4ce3e96e2c6--nicnet-id=d90f8e81-250c-442c-b0a6-bb68c1f087b7,v4-fixed-ip=10.13.250.202--flavor=win2008_app_8c_32G_500Gwin2008_app_202

2.8.3.2qemu-imghelpconvert2.8.3.3、迁移虚拟机1、查看热迁移命令[root@Compute-40-F2-E9-11-A8-09~]#novahelplive-migrationusage:novalive-migration[--block-migrate][--disk-over-commit][]Migratesarunninginstancetoanewmachine.Positionalarguments:NameorIDofserver.destinationhostname.Optionalarguments:--block-migrateTrueincaseofblock_migration.(Default=False:live_migration)--disk-over-commitAllowovercommit.(Default=False)2、热迁移虚拟机(必须有共享存储)novalive-migrationwin2008_test_241Compute-40-F2-E9-11-A8-41.kvm.cloud3、冷迁移虚拟机(无法指定目标物理主机)usage:novamigrate[--poll]Migrateaserver.Thenewhostwillbeselectedbythescheduler.novamigrateCompute-40-F2-E9-11-A8-41.kvm.cloudERROR:NoserverwithanameorIDof"Compute-40-F2-E9-11-A8-41.kvm.cloud"exists.冷迁移过程novamigratewin2008_app_202状态1:qemu-imgconvert-fqcow2-Oqcow2/var/lib/nova/instances/854e8e0a-5f9b-4dc2-920b-7230074df417_resize/disk/var/lib/nova/instances/854e8e0a-5f9b-4dc2-920b-7230074df417_resize/disk_rbase2013-12-0709:37:37.7246672ERRORnova.virt.libvirt.driver[-]Gettingdisksizeofinstance-000001ec:[Errno2]Nosuchfileordirectory:

"/var/lib/nova/instances/854e8e0a-5f9b-4dc2-920b-7230074df417/disk"手动干预:cp-r854e8e0a-5f9b-4dc2-920b-7230074df417_resize/disk854e8e0a-5f9b-4dc2-920b-7230074df417/状态2:ssh192.168.200.236rsync--server-Sze.Ls./var/lib/nova/instances/854e8e0a-5f9b-4dc2-920b-7230074df417/disk状态3:迁移完成重启能ping通,进系统非常卡,伴随蓝屏win2008_app_202Compute-40-F2-E9-11-B4-59.kvm.cloud4、热迁移虚拟机(无共享存储)过程:迁移源主机虚拟机镜像文件(700MB)到到目标主机,如果没有base文件,拷贝base到目标查看虚拟机镜像id:novalist查看实例id:virshlist-all查看虚拟机和实例的对应关系:novashowvm_name命令:novalive-migrationwin2008_app_242Compute-40-F2-E9-11-9B-F9.kvm.cloud--block-migrate2.8.3.4、修改虚拟机内存将云主机win2008_app_203由8c_32G_500G,资源更改为8c_16G_300Gnovaresizewin2008_app_203win2008_app_8c_16G_300G

(1)convert操作(2)貌似要迁移到其他主机ssh192.168.200.236rsync--server-Sze.Ls./var/lib/nova/instances/62970fd6-5b96-4262-b2f5-f1782c927326/diskrsync--sparse--compress/var/lib/nova/instances/62970fd6-5b96-4262-b2f5-f1782c927326_resize/disk_rbase192.168.200.236:/var/lib/nova/instances/62970fd6-5b96-4262-b2f5-f1782c927326/disk(3)结果:主机变为8c_16G_500G1、查看本节点的虚拟机virshlistvirshdominfo52、修改虚拟机内存顺序停止虚拟机----修改maxmem-----启动-----修改setmemvirshshutdown5virshsetmaxmeminstance-000000f932GBvirshstartinstance-000000f9virshsetmeminstance-000000f94096MB(3)修改虚拟机内存命令virsheditvirshdefine(1)确定要迁移的云主机名字及flavor[root@CloudController~]#novalist|5938fe72-2678-434a-9d5c-12a56e0ec4f7|win2008_app1_202|RESIZE|Vlan100=10.13.250.202|novashowwin2008_app1_202instance-000001cd[root@CloudController~]#novaflavor-list(2)更改云主机内存novaresizeinstance-000001cdwin2008_app_16c_16G_300G

ERROR:NoserverwithanameorIDof"instance-000001cd"exists.novaresizewin2008_app1_202win2008_app_16c_16G_300Gcd/var/lib/nova/instancescpb8dfcf87-50fa-47b6-b664-a55c45890349_resize/diskb8dfcf87-50fa-47b6-b664-a55c45890349出现下面界面,confirm即可发现win2008_app1_202被迁移到其他的主机上win2008_app1_202Compute-40-F2-E9-11-B4-59.kvm.cloudwin2008_app_16c_16G_300Gactive2013-12-0504:04:33定义一个kvm虚拟机#virshdefine/usr/local/kvm/centvm3.xml在后台,这个命令拷贝该xml文件到/etc/libvirt/qemu目录,文件名为xml里定义的kvm名称。并且正式定义一个新的kvm。查看kvm虚拟机#virshlist2.8.3.5、修改虚拟机硬盘为1100GB1、新建flavorwin2008_app_8c_16G_1100G2、修改实例硬盘大小novaresizewin2008_app_204win2008_app_8c_16G_1100G

3、确认磁盘更改成功2.8.3.7、新建虚拟机1、物理主机资源:80/1000可用VCPU,129/360GB内存,硬盘不能超过2TB删除vm资源:48VCPU,62GB内存,1960GB硬盘+32GB交换localhost:/lbs_vms6.0T43G5.6T1%/var/lib/nova/instances可用物理主机资源:32/1000可用VCPU,65GB/360GB测试结果:vcpu通过虚拟可达1000个,内存只能使用实际内存空间。2、最大虚拟机资源测试160VCPU+63GBRAM48C+64GB内存+1960GB硬盘+32GB交换64C+78GB内存+160GB硬盘+16GB交换,error100C+62GB内存+160GB硬盘+16GB交换,成功200C+62GB内存+160GB硬盘+16GB交换,error150C+62GB内存+160GB硬盘+16GB交换,成功界面如下:为何任务管理器只能看到8颗CPU,但是设备管理器-处理器显示150个

(1)新建虚拟机

创建云主机OS结果:8C+15.6GBRACM+300GB硬盘+16GBSWAP(2)新建最大虚拟机48C+64000MB内存+1960GB硬盘+32GB交换时间11:36----12:07完成2.8.3.8、虚拟机和物理主机的资源比例(1)修改内存比例修改控制节点、所有主机节点的nova.conf配置文件

vi/etc/nova/nova.conf增加如下列:ram_allocation_ratio=2重新启动服务/etc/init.d/openstack-nova-computerestart(2)修改CPU比例默认为162.8.3.9、云主机网络能ping通,但是防火墙禁止端口访问基于安全理由,SUSECloud在预设值下,防火墙会关闭所有外来连线,要从外面网路进入虚拟机器就要修改Nova的防火墙规则。要开启埠号容许ping、SSH和TCP/UDP。nova secgroup-add-rule default icmp -1 -1 0.0.0.0/0 nova secgroup-add-rule default tcp 22 22 0.0.0.0/0 nova secgroup-add-rule default tcp 1 65535 0.0.0.0/0 nova secgroup-add-rule default udp 1 65535 0.0.0.0/0 novasecgroup-listnovasecgroup-list-rulesdefault[root@Compute-40-F2-E9-11-B4-E1~]#rpm-qa|grepopenvswitchopenstack-quantum-openvswitch-2013.1.4-3.el6.noarchopenvswitch-1.11.0_8ce28d-1.el6ost.x86_64最终解决办法:(1)安装以下包openvswitch-1.11.0_8ce28d-1.el6ost.x86_64.rpm(2)rpm-Uvhkernel*.rpm(3)/etc/init.d/quantum-openvswitch-agentstop/etc/init.d/openvswitchstoprpm-Uvhopenvswitch-1.11.0_8ce28d-1.el6ost.x86_64.rpm(4)rpm-eopenvswitch-kmod-1.9.3-1.el6.x86_64rpm-ekmod-openvswitch-1.4.2-1.el6.x86_64

reboot(5)删除network,重建network、subnetwork(6)创建云主机必须指定ip地址

[root@Compute-40-F2-E9-11-B4-E1openvswitch]#iptables-L-n-vChainINPUT(policyACCEPT1897Kpackets,1823Mbytes)pktsbytestargetprotoptinoutsourcedestination1148K1691Mnova-compute-INPUTall--**0.0.0.0/00.0.0.0/000ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpts:613:6174576ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:11100ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpts:34865:348852611K4721MACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpts:49352:49372210931158KACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpts:24007:2400800ACCEPTtcp--**0.0.0.0/00.0.0.0/0stateNEWtcpdpt:1650900ACCEPTtcp--**0.0.0.0/00.0.0.0/0stateNEWtcpdpts:49152:4926100ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:204900ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:11100ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:3260312091740KACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpts:5900:599900ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:2400700ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:63432887288KACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:566600ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:865200ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:865200ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:865100ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:865100ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:865000ACCEPTtcp--**0.0.0.0/00.0.0.0/0

tcpdpt:865000ACCEPTudp--**0.0.0.0/00.0.0.0/0udpdpt:864900ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:8649ChainFORWARD(policyACCEPT807packets,79995bytes)pktsbytestargetprotoptinoutsourcedestination92286274nova-filter-topall--**0.0.0.0/00.0.0.0/045037640nova-compute-FORWARDall--**0.0.0.0/00.0.0.0/0ChainOUTPUT(policyACCEPT4086Kpackets,2935Mbytes)pktsbytestargetprotoptinoutsourcedestination4976K3461Mnova-filter-topall--**0.0.0.0/00.0.0.0/0994K664Mnova-compute-OUTPUTall--**0.0.0.0/00.0.0.0/0Chainnova-compute-FORWARD(1references)pktsbytestargetprotoptinoutsourcedestinationChainnova-compute-INPUT(1references)pktsbytestargetprotoptinoutsourcedestinationChainnova-compute-OUTPUT(1references)pktsbytestargetprotoptinoutsourcedestinationChainnova-compute-inst-464(1references)pktsbytestargetprotoptinoutsourcedestination00DROPall--**0.0.0.0/00.0.0.0/0stateINVALID1549240ACCEPTall--**0.0.0.0/00.0.0.0/0stateRELATED,ESTABLISHED8660nova-compute-providerall--**0.0.0.0/00.0.0.0/04420ACCEPTall--**10.13.250.0/240.0.0.0/000ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:224240ACCEPTicmp--**0.0.0.0/00.0.0.0/000ACCEPTtcp--**0.0.0.0/00.0.0.0/0multiportdports1:6553500ACCEPTudp--**0.0.0.0/00.0.0.0/0multiportdports1:6553500nova-compute-sg-fallbackall--**0.0.0.0/0

0.0.0.0/0Chainnova-compute-inst-465(1references)pktsbytestargetprotoptinoutsourcedestination00DROPall--**0.0.0.0/00.0.0.0/0stateINVALID00ACCEPTall--**0.0.0.0/00.0.0.0/0stateRELATED,ESTABLISHED00nova-compute-providerall--**0.0.0.0/00.0.0.0/000ACCEPTall--**10.13.250.0/240.0.0.0/000ACCEPTtcp--**0.0.0.0/00.0.0.0/0tcpdpt:2200ACCEPTicmp--**0.0.0.0/00.0.0.0/000ACCEPTtcp--**0.0.0.0/00.0.0.0/0multiportdports1:6553500ACCEPTudp--**0.0.0.0/00.0.0.0/0multiportdports1:6553500nova-compute-sg-fallbackall--**0.0.0.0/00.0.0.0/0Chainnova-compute-local(1references)pktsbytestargetprotoptinoutsourcedestination1629900nova-compute-inst-464all--**0.0.0.0/010.13.250.20400nova-compute-inst-465all--**0.0.0.0/010.13.250.2053.8.4openvswitchovs-vsctl查询和更新ovs-vswitchd的配置;ovs-appctl发送命令消息,运行相关daemon;使用命令ovs-vsctlshow可以看到结果[root@dell4~]#ovs-vsctlshow[root@Compute-40-F2-E9-11-A8-41~]#ovs-vsctlshow5fa6416f-ebbd-4f62-a83c-d811535de807Bridgebr-exPortbr-exInterfacebr-extype:internal

Bridgebr-intPortbr-intInterfacebr-inttype:internalPortint-br-phyInterfaceint-br-phyBridgebr-phyPortphy-br-phyInterfacephy-br-phyPort"bond1"Interface"bond1"Portbr-phyInterfacebr-phytype:internalovs_version:"1.4.2"启动虚拟交换机ps-ef|grepovs成功后,会有三个进程,一个ovs-brcompatd进程,一个ovs-vswitchd进程,一个ovsdb-server进程列出所有网桥ovs-vsctllist-br判断网桥是否存在ovs-vsctlbr-existsbr0echo$?//0表示存在,否则不存在将网络接口eth0挂接到网桥br0上ovs-vsctladd-portbr0eth0列出挂接到网桥br0上的所有网络接口ovs-vsctllist-portsbrint-br-phyqvo0687563b-33qvo120cb10f-87qvo57090e3f-acqvo5c21a6d1-f6qvo639f9168-24qvo63dc6837-61qvo80392e46-adqvof4e92a70-4b列出已挂接eth0网络接口的网桥

ovs-vsctlport-to-breth0测试tcpdump–ieth0查看虚拟机端口uuidovs-vsctllistport查看端口[root@Compute-40-F2-E9-11-B4-E1~]#ovs-ofctldump-portsbr-intOFPST_PORTreply(xid=0x1):6portsport21:rxpkts=18,bytes=2112,drop=0,errs=0,frame=0,over=0,crc=0txpkts=1752,bytes=174182,drop=0,errs=0,coll=0port20:rxpkts=2899,bytes=383975,drop=0,errs=0,frame=0,over=0,crc=0txpkts=420,bytes=71990,drop=0,errs=0,coll=0port14:rxpkts=492,bytes=99622,drop=0,errs=0,frame=0,over=0,crc=0txpkts=31215,bytes=3068887,drop=0,errs=0,coll=0port16:rxpkts=715,bytes=66977,drop=0,errs=0,frame=0,over=0,crc=0txpkts=31067,bytes=3108098,drop=0,errs=0,coll=0port15:rxpkts=17,bytes=1194,drop=0,errs=0,frame=0,over=0,crc=0txpkts=31639,bytes=3162485,drop=0,errs=0,coll=0port65534:rxpkts=6,bytes=468,drop=0,errs=0,frame=0,over=0,crc=0txpkts=169281,bytes=15491521,drop=0,errs=0,coll=03.8.5libvirt3.8.5.1配置1、libvirt的配置文件libvirt相关的配置的配置文件都在/etc/libvirt/目录之中,(1)/etc/libvirt/libvirt.conflibvirt.conf文件是用于配置一些常用libvirt连接(通常是远程连接)的别名cat/etc/libvirt/libvirt.confuri_aliases=["remote1=qemu+ssh://root@192.168.93.201/system",]其中,配置了remote1这个别名用于指代qemu+ssh://root@192.168.93.201/system这个远程的libvirt连接,有这个别名后,就可以在virsh等工具或者自己写代码调用libvirtAPI时使用这个别名而不需要写完整的、冗长的URI连接标识了。用virsh使用这个别名,连接到远程的libvirt上查询当前已经启动的客户机状态,然后退出连接,命令行操作如下:

[root@rhel6u3-gakvm_demo]#virsh-cremote1root@192.168.93.201′spassword:Welcometovirsh,thevirtualizationinteractiveterminal.Type: ‘help’forhelpwithcommands重新loadlibvirt配置命令servicelibvirtdreload(2)/etc/libvirt/libvirtd.conflibvirtd.conf是libvirt的守护进程libvirtd的配置文件,修改后需要让libvirtd重新加载配置文件(或重启libvirtd)才会生效。 (3)/etc/libvirt/qemu.confqemu.conf是libvirt对QEMU的驱动的配置文件,包括VNC、SPICE等和连接它们时采用的权限认证方式的配置,也包括内存大页、SELinux、Cgroups等相关配置。(4)/etc/libvirt/qemu/目录qemu目录下是存放使用QEMU驱动的域的配置文件3.8.5.2libvirtd的使用libvirtd是一个作为libvirt虚拟化管理系统中的服务器端的守护程序,如果要让某个节点能够用libvirt进行管理(无论是本地还是远程管理),都需要在这个节点上运行着libvirtd这个守护进程,以便让其他上层管理工具可以连接到该节点,libvirtd负责执行其他管理工具发送它的虚拟化管理操作指令。libvirt的客户端工具(包括virsh、virt-manager等)可以连接到本地或远程的libvirtd进程,以便管理节点上的客户机(启动、关闭、重启、迁移等)、收集节点上的宿主机和客户机的配置和资源使用状态。“servicelibvirtdstart”命令表示启动libvirtd,“servicelibvirtdrestart”表示重启libvirtd,“servicelibvirtdreload”表示不重启服务但是重新加载配置文件(即/etc/libvirt/libvirtd.conf配置文件)。3.8.5.2(bridge)网络配置1、network.xml2、Java代码virsh net-list --all 1.Name State Autostart

1.----------------------------------------- 2.default active yes 3.local active yes 3、Xml代码虚拟机domain的配置文件中interface的配置段:1. 2.

您可能关注的文档

- aix6.1 + hacmp5.5 + oracle10gr2 rac实施手册

- 某投资公司绩效管理体系实施手册

- 天津保税区,空港经济区生产经营单位安全生产标准化基本要求实施手册

- 02十倍成长网络商学院项目实施手册

- aix6.1 + hacmp5.5 + oracle10gr2 rac实施手册

- 劳动关系统计报表实施手册

- 安全生产风险分级管控实施手册(市局)

- onlyit实施手册ver2.0

- 电子证照共享服务平台实施手册

- 河北联通终端加入域实施手册(精简版)1

- 建设工程施工企业项目管理办法及实施手册-项目经理部

- 金地高管招聘测试实施手册

- 天音通信管理培训生训练营计划项目实施手册

- 创智信息绩效管理体系实施手册

- sql+2005集群实施手册

- epc工程总承包项目管理实施手册_secret

- 广告促销计划流程实施手册

- 建筑业10项新技术推广应用与标准规范实施手册new